Официальный веб -сайт подлинный и глубокий практика OCR, основанный на глубоком обучении, распознавание текста Liu Shuchun поздравил Ma jianqi wang jiajun машинный обучение.

Вес товара: ~0.7 кг. Указан усредненный вес, который может отличаться от фактического. Не включен в цену, оплачивается при получении.

Описание товара

- Информация о товаре

- Фотографии

Алгоритм Команда Алибабы местной научно -исследовательской института, написанная автором хорошо известного алгоритма текста сцены, идеологического столкновения промышленного применения и академического резки!Большое количество случаев предоставляется из компонентов, алгоритмов, внедрения и инженерных приложений, таких как технология OCR, основанные на глубоком обучении.

Основная информация | |

| |

наименование товара: |   глубокая практика OCR: распознавание текста на основе глубокого обучения |

делать   | Лю Шучун поздравляю Ма Цзяньки Ван Цзяджун и т. Д. |

город  поле  цена: |   89,00 Юань |

ISBN номер: | 9787111654049 |

Дата публикации: | 2020-05 |

Страница &Nbsp; номер: | 324 |

Характер &Nbsp; номер: |   128 тысяч слов |

вне   Общество: |   Machinery Industry Press |

Оглавление |

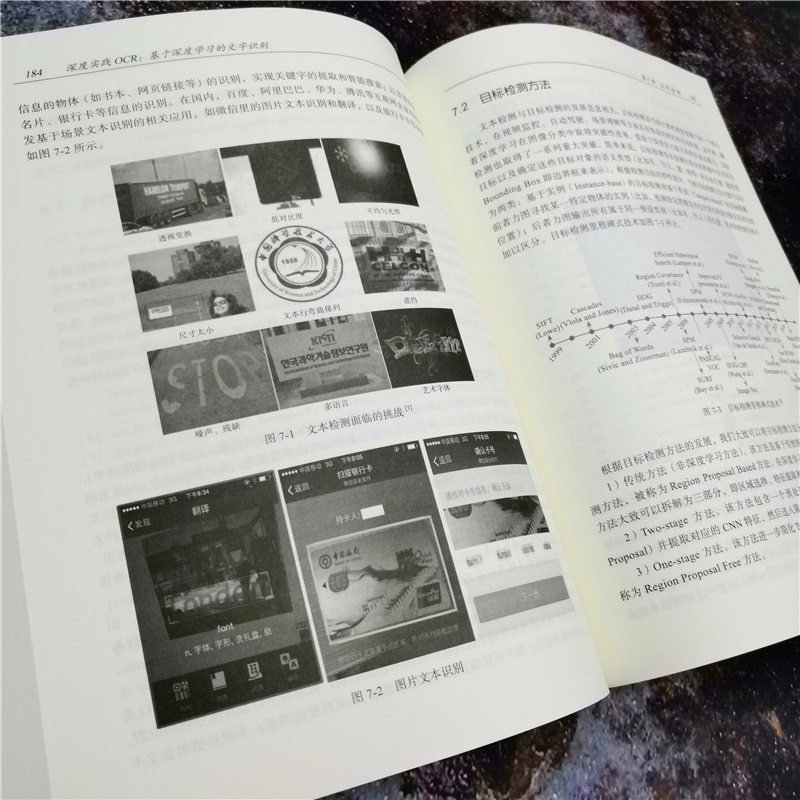

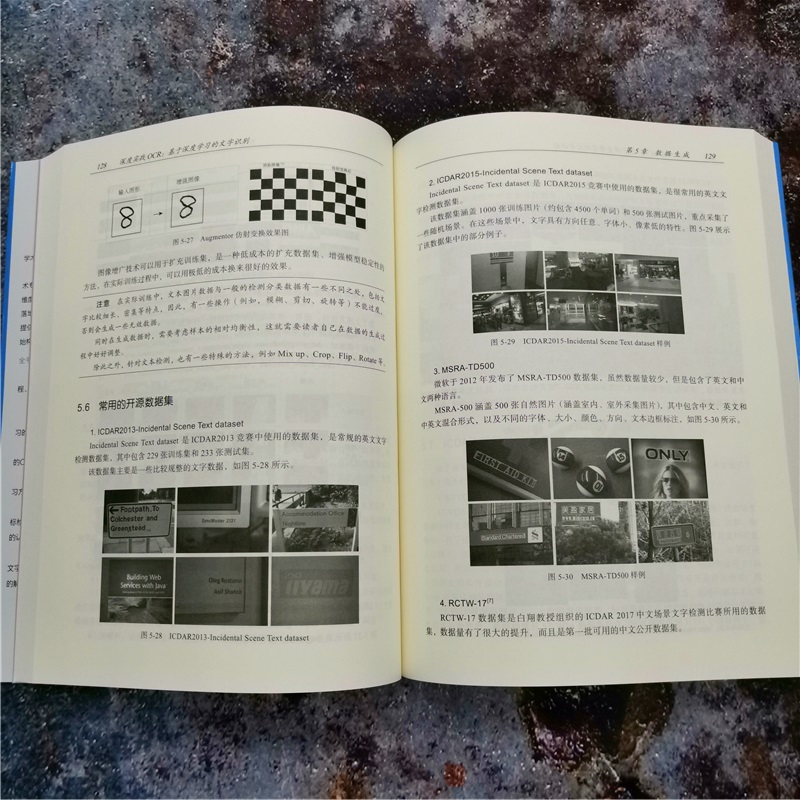

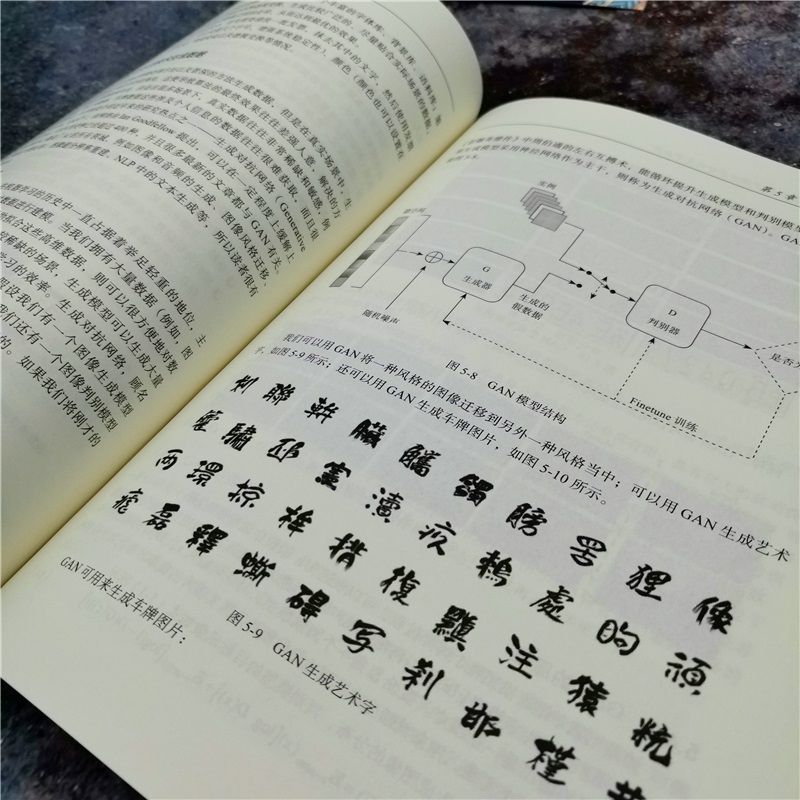

Рекомендация Предисловие Глава 1 Введение 1 1.1 История развития OCR в потоке искусственного интеллекта 1 1.1.1 Традиционный метод OCR Общий процесс 3 1.1.2 Общий процесс на основе метода глубокого обучения OCR 5 1.2 Обнаружение текста 6 1.3 Распознавание текста 8 1.4 Статус промышленного приложения кво 10 1.5 Сводка этой главы 11 1.6 Ссылки 11 Глава 2 предварительная обработка изображения 13 2.1 Двойное значение 13 2.1.1 Глобальный пороговый метод 13 2.1.2 Локальный пороговый метод 17 2.1.3 Методы, основанные на глубоком обучении 20 2.1.4 Другие методы 22 2.2 плавное и шум 26 2.2.1 Космический фильтр 26 2.2.2 Пороговая пустынная пустыня спасения 28 2.2.3 Неволокальные методы 29 2.2.4 Метод на основе нейронных сетей 33 2.3 Угловое обнаружение и коррекция 35 2.3.1 Hoff Transformation 36 2.3.2 Трансформация радона 38 2.3.3 Метод на основе PCA 38 2.4 Бой 39 2.5 Ссылки 43 Глава 3 Традиционные методы машинного обучения введение 45 3.1 Метод извлечения признаков 45 3.1.1 Извлечение функций на основе структурных форм 45 3.1.2 Извлечение на основе геометрического распределения 61 3.2 Модель метода классификации 63 3.2.1. 63 3.2.2 k почти соседний алгоритм 65 3.2.3 Восприятие много -слоя 70 3.3 Фактический бой: идентификация идентификационного номера 71 3.3.1 Код основного 71 3.3.2 Результаты испытаний 78 3.4 Сводка этой главы 79 3.5 Ссылки 79 Глава 4 Основные знания глубокого обучения 80 4.1 Единственная нейронная сеть 80 4.1.1 Нейроны 80 4.1.2 Машина восприятия 81 4.2 Двойная нейронная сеть 82 4.2.1 Введение в нейронную сеть с двойным слоем 82 4.2.2 Обычно используемые функции активации 83 4.2.3 Алгоритм обратной связи 86 4.3 Глубокое обучение 87 4.3.1 Служба нейронная сеть 88 4.3.2 Общий алгоритм оптимизации 90 4.4 Навыки обучения сети 92 4.4.1 Инициализация стоимости прибыли 92 4.4.2 L1/L2 регуляризация 93 4.4.3 Dropout 94 4.5 Бой 95 4.6 Ссылки 97 Глава 5 Генерация данных 99 5.1 Фоновое введение 99 5.2 Традиционные отдельные символы генерация данных OCR 100 5.3 генерация данных OCR на основе глубокого обучения 101 5.3.1 Раздел данных об обнаружении текста 101 5.3.2. Детективная генерация изображений 103 5.3.3 Другие методы 112 5.3.4 Генерация данных идентификации 113 5.4 Сгенерировать данные с помощью технологии GAN 114 5.4.1 GAN FOUNY ВВЕДЕНИЕ 114 5.4.2 Принцип Ган 116 5.4.3 Варианты Гана 117 5.5 Увеличение изображения 123 5.5.1 Общие методы улучшения изображения 123 5.5.2 Метод глубокого обучения 126 5.6 Общий набор данных с открытым исходным кодом 128 5.7 Набор задач и данных ICDAR 131 5.8 Резюме этой главы 138 5.9 Ссылки 138 Глава 6 Расширенный метод глубокого обучения 140 6.1 Модель классификации изображений 140 6.1.1 LeNet5 140 6.1.2 AlexNet 142 6.1.3 VGGNet 143 6.1.4 GoogLeNet 144 6.1.5 ResNet 147 6.1.6 DenseNet 151 6.1.7 SENet 153 6.1.8 Легкая сеть 154 6.2 Европейская нейронная сеть 154 6.2.1 сеть RNN 154 6.2.2 GRU 156 6.2.3 Реализация GRU 158 6.2.4 LSTM Network 160 6.3 Seq2Seq 163 6.4 CTC Loss 164 6.4.1 Подробное объяснение алгоритма 166 6.4.2 Прайд Распространение 168 6.4.3 пройти, чтобы распространяться на 173 6.4.4 впереди/задний алгоритм 173 6.4.5 Функция алгоритма CTC 174 6.4.6 Анализ кода 175 6.5 Attention 178 6.6 Сводка этой главы 181 6.7 Ссылки 182 Глава 7 Текстовый тест 183 7.1 Значение исследования 183 7.2 Метод обнаружения цели 185 7.2.1 Условия обнаружения цели 186 7.2.2 Традиционные методы тестирования 189 7.2.3 Двухэтапный метод 195 7.2.4 Одноэтапный метод 210 7.3 Метод обнаружения текста 217 7.3.1 Традиционный метод обнаружения текста 217 7.3.2 Метод обнаружения текста на основе глубокого обучения 222 7.4 Сводка этой главы 228 7.5 Ссылки 228 Глава 8 Признание персонажа 232 8.1 Обзор задачи 232 8.2 Описание набора данных 233 8.2.1 Значение набора данных 233 8.2.2 Внедрение наборов данных общего распознавания 234 8.3 Индикаторы оценки 238 8.3.1 Расстояние редактирования 239 8.3.2 Анти -химическое расстояние редактирования 239 8.3.3 Точность характера 239 8.3.4 Уровень точности слов 239 8.3.5 Методы оценки, связанные с контекстом 239 8.4 Введение в основные алгоритмы 240 8.4.1 Традиционные оптические методы 240 8.4.2 Полны методов глубокого обучения 244 8.5 CRNN Model Combat 274 8.5.1 Введение 274 8.5.2 Операционная среда 274 8.5.3 Тестовая часть объяснения 274 8.5.4 Результаты тестового прогона 279 8.5.5 Секция обучения 279 8.5.6 Используйте набор данных ICDAR2013 для обучения модели CRNN 282 8.6 Резюме этой главы 284 8.7 Ссылки 285 ГЛАВА 9 ПОСТОКА ОКР -метод обработки 288 9.1 Коррекция ошибок текста 288 9.1.1 BK-tree 289 9.1.2 Китайская китайская модель коррекция ошибок модели 293 9.2 Текст структурирован 297 9.2.1 Сопоставление шаблонов 298 9.2.2 Текстовая классификация 300 9.3 Резюме этой главы 304 9.4 Ссылки 304 Глава 10 Анализ макета 306 10.1 Анализ макета подробный объяснение 306 10.2 Комплексное распознавание версий 309 10.3 Восстановление документа 310 10.4 Резюме этой главы 311 10.5 Ссылки 311 |

краткое введение |

краткое введение Это книга ORC, которая интегрирует передовой инженерный практический опыт в бизнес -сообществе и технологии и мысли режущихся в академическом мире. Эта книга руководит техническими экспертами команды Алгоритма местных исследований местных исследований в области местных исследований.В книге анализируются математические принципы, лежащие в основе алгоритма, по шагам обеспечивает большое количество простой реализации кода и помогает читателям построить алгоритм OCR из нулевого фундамента. В общей сложности 9 глав в книге: Глава 1 представляет историю развития, концепции и промышленные применения технологии ORC с макро -точки зрения; Глава 2 объясняет метод предварительной обработки изображения OCR; Глава 3 ~ 4 представляет соответствующую основу традиционных методов машинного обучения и глубокого обучения; Глава 5 объясняет генерацию данных OCR на основе традиционных методов и методов глубокого обучения; Глава 6 объясняет некоторые расширенные методы глубокого обучения, связанные с OCR, что удобно для читателей, чтобы понять последующие детали тестирования и идентификации; Глава 7 объясняет технологию обнаружения текста, обнаруживает обнаружение текста от общей цели и шаг за шагом углубляет понимание читателя проблемы текстового тестирования; Глава 8 Обсудите соответствующие технологии распознавания текста. После позиционирования позиции текста вам необходимо дополнительно проанализировать содержание текста; Глава 9 представляет некоторые методы пост -обработки OCR. |